Reward相关

- reward设置成[-1, 1]是normalized之后的结果,一般reward的设置是根据reward function或是根据一些经验值,比如在一些经典的迷宫场景中,reward的设置一般是一步-1的reward,作用是鞭策agent加快学习过程,在一些悬崖的地方会设置很大的负reward比如-200,这是因为这些地方会直接导致游戏结束,所以reward会很大,有点类似于自动驾驶中的撞车。不过总体来说reward的设置多数是根据经验并结合reward function

- 强化学习本身也是一个搜索和优化的过程,肯定存在一些局部最优点,agent在学习的过程中很可能会收敛到局部最优点,解决方法主要是通过exploration来扩大搜索范围,防止agent因为没有见过相关的state而收敛到现有的state,目前也有一种方法是学习anti-goal,可以参考

reward shaping

关于reward shaping 详细内容点这跳转:原文

reward shaping是强化学习中的一个具有普适性的研究方向,即有强化学习影子的地方总能够尝试用reward shaping进行改进。本文准备介绍几篇近两年的ICLR在reward shaping上进行过研究的工作,并尝试总结出这些研究的一些共通点。

通常来说,reward shaping的动机主要有两点:

1、为了解决long-term credit assignment问题,即智能体只能到某个游戏关卡结束以后才能获得实质性的奖励值,其他时候的奖励都是零,从而导致智能体无法认识到某个状态下采取某个动作对最后奖励的贡献程度,识别不出关键动作。

2、在很多较为困难的Atari游戏场景中,往往需要智能体进行大量的exploration以后才能够收获到实质性的奖励,若在exploration中所有情况的奖励都是零,则智能体就没有进行exploration的动力,因此需要在智能体进行exploration的时候设计额外的奖励促使智能体去exploration。

本文的行文顺序为:reward shaping的基础理论–>reward shaping的有关论文–>reward shaping的个人思考

一、reward shaping的基础理论

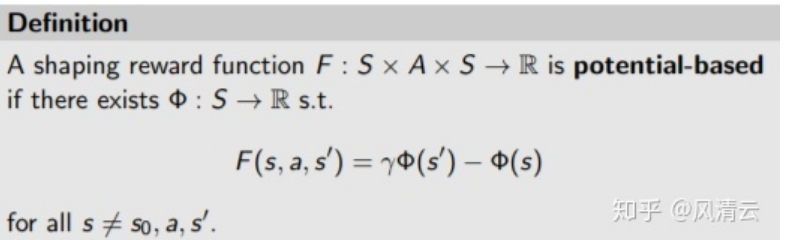

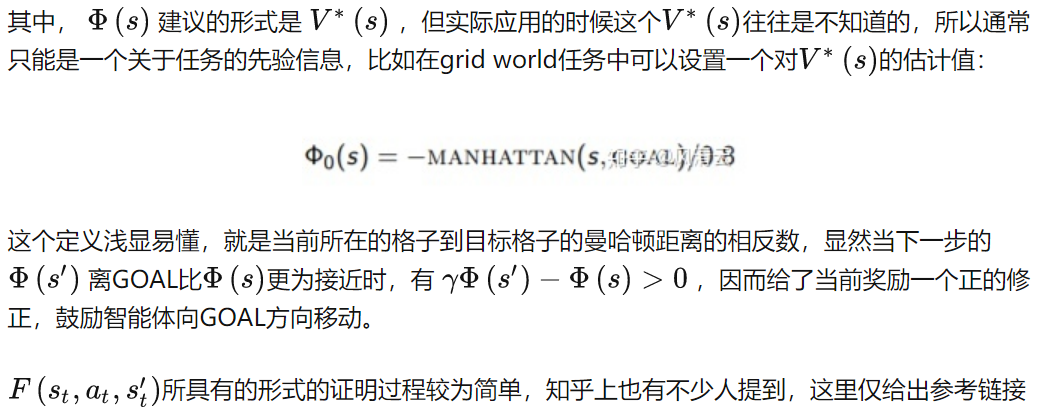

基于前面两个动机,可以知道reward shaping是需要对一个episode中的每一个 $(s_t,a_t)$ 都计算一个额外奖励,即除了原始奖励 $R(s_t,a_t,s’t) $以外还需要计算一个 $F(s_t,a_t,s’{t})$ 作为额外奖励。

Andrew Y. Ng在2016年给出了这个额外奖励所需要具备的条件:

PPO

trick

Generalized Advantage Estimation:这个技巧来自文献:Hign-dimensional continuous control using generalized advantage estimation。Input NormalizationValue Clipping:与策略截断类似,将值函数进行一个截断。Relu activation with Orthogonal Initialization:Gredient Clipping:梯度更新不要太大。Layer Normalization:这个技巧来自文献:Regularization matters in policy optimization-an empirical study on continuous control。Soft Trust-Region Penalty:这个技巧来自文件:Revisiting design choices in proximal policy optimization。